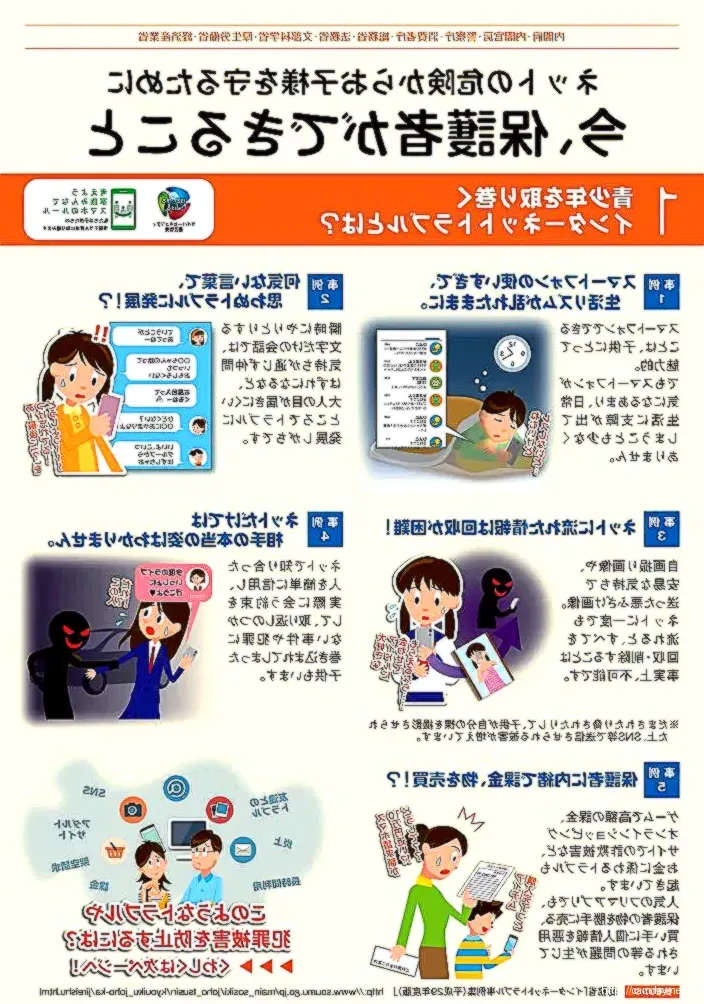

米Meta社が運営するインスタグラムは、2023年9月17日に発表した新機能により、16歳未満のユーザーに対する利用制限を強化することが明らかになった。この取り組みは、日本を含む世界中で実施される予定で、未成年の利用者の安全を守るための対策が強化される。特に、SNSを利用する若者が直面する様々なリスクに対応する形となる。

新機能の詳細

新たに導入される「ティーンアカウント」では、16歳未満のユーザーは自動的に非公開アカウントに移行させられる。この設定により、フォロワーのみがその投稿を閲覧できる。具体的には、以下のような機能が追加される。

| 機能 | 説明 |

|---|---|

| 非公開アカウント設定 | すべてのティーンアカウントが自動的に非公開に設定され、承認されたフォロワーのみが閲覧可能。 |

| メッセージ制限 | フォローしているユーザーや既に接触のあるユーザーからのみメッセージを受信。 |

| センシティブなコンテンツの制限 | 発見やリール機能で表示されるコンテンツは最も厳しい設定が適用される。 |

| タグ付けやメンションの制限 | フォロワーからのみ可能、また不快な言葉やフレーズは自動で除外される。 |

| おやすみモード | 午後10時から午前7時まで通知が止まり、ダイレクトメッセージには自動返信が送信される。 |

このような新しい機能に参加することで、インスタグラムは自社のプラットフォームを利用する未成年者のリスクを減少させようとしている。

親の監視機能も強化

新機能の中では、保護者が子どものメッセージのやりとりを把握できるようにする設定も含まれている。これにより、親は子どもが過去7日間にメッセージをやり取りしていた相手を確認できるため、オンライン上でのつながりをより厳格に管理することが可能になる。また、親は子どもに特定の時間帯の利用制限や、1日の利用時間の設定を行うこともできる。これにより、SNSの過度な利用を防ぎ、子どもたちの健康的な生活を促進しようとしている。

インスタグラムの背景と社会的影響

昨今、アメリカやイギリスをはじめとする多くの国で未成年者がSNSを通じて性的搾取やいじめの被害に遭う事件が急増している。米国では未成年がSNSから知り合った大人によって被害を受ける事例が社会問題化しており、2023年1月には米上院司法委員会がメタや他のSNS企業の幹部を召喚し、未成年者保護のための対策を強化するよう迫った。

このような背景から、インスタグラムはより安全なオンライン体験を提供するために、今回の強化された制限を導入することになった。アダム・モッセリ氏は「これは保護者の懸念に応えるものである」と明言しており、その決意が伺える。

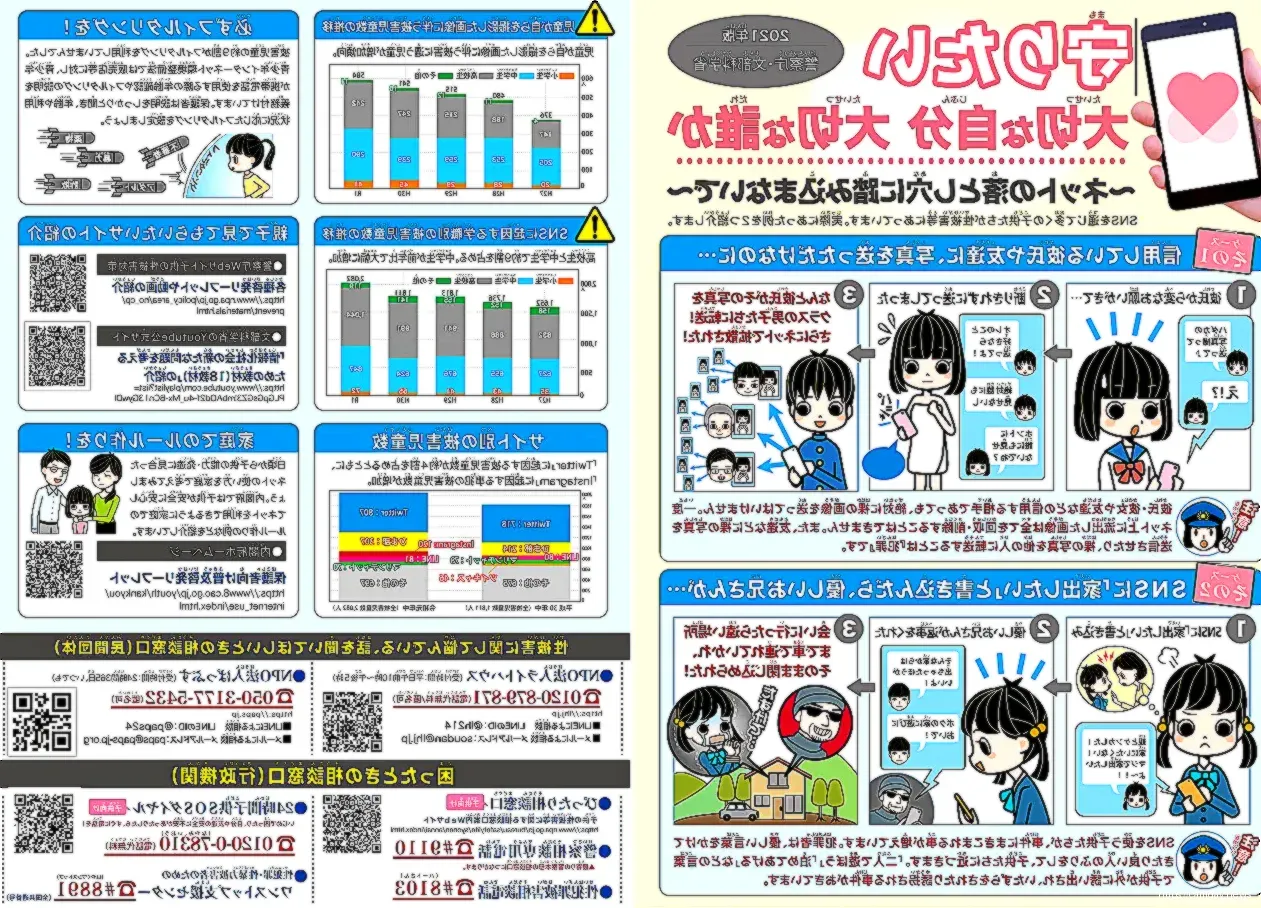

統計データ

以下の統計は、未成年ユーザーのSNS利用に伴うリスクを示している。

| カテゴリー | データ |

|---|---|

| SNSトラブルの件数 | アメリカでは未成年がSNS利用によるトラブルに巻き込まれる件数が年々増加中。 |

| 性的リスクに関する調査 | 調査によると、SNSを利用する未成年の約30%が知らない人から不適切なメッセージを受取った経験あり。 |

| 保護者の懸念 | 80%の親が子どもがSNS上で遭遇するリスクに対して強い懸念を抱いている。 |

これらのデータは、SNSの利用におけるリスクが未成年者にとって非常に高いことを示しており、インスタグラムの新しい取り組みが求められる理由を裏付けている。

利用者の反応と期待

多くの親からは、この新機能に対して期待の声が上がっている。ある親は、「この変更によって、子どもがネット上でどのように過ごしているかをより安心できる」と話している。また、子どもたち自身も、「知らない人と接触するリスクが軽減されることで、もっと安全に楽しむことができる」と語っている。

しかし、一方で懸念の声も存在する。SNSに依存するあまり、リアルな交流が希薄になってしまうことを心配する意見もある。SNSが持つ重要なコミュニケーションの場としての役割も忘れてはならない。

年齢確認と技術的対応

インスタグラムは、年齢詐称による問題に対処するために、年齢確認の手続きを厳格にする方針を打ち出している。新規アカウント作成時には身分証明書の提示を求めるほか、AIによる行動分析で年齢を推定する技術も導入される。この技術により、偽の年齢でアカウントを作成することが難しくなる。

まとめ

インスタグラムの「ティーンアカウント」導入は、16歳未満のユーザーをより安全に保護するための重要なステップである。社会全体が未成年者の安全に対する意識を高める中で、このような取り組みはますます重要性を増してきている。今後も、親と子どもが共に安心してSNSを利用できる環境が整っていくことが期待される。